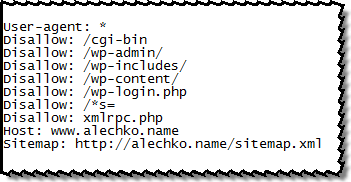

פרוטוקול נפוץ באינטרנט מגדיר למנועי חיפוש ורובוטים את אופן סריקת אתר, למידע נוסף וויקי באנגלית ואתר רשמי. אתרים רבים אינם משתמשים ב robots.txt. אני מכווה שאתם משתמשים בו, לכן אני כותב על טעויות נפוצות, שיפורים ושינויים. קובץ robots.txt משפיע באופן ישיר ועקיף על SEO. לפעמים גם פוסט או מאמר שנכתב במיוחד למנועי חיפוש נחסם בגלל טעות אחת בקובץ.

אני משתמש במערכת וורדפרס, ולצורך דוגמה אשתמש במערכת זו.

כמו שניתן לראות, אני חוסם לרובוטים לסרוק את תיקיות וקבצי מערכת. כל זה נועד למנוע סריקה מיותרת ולשלוח למנועי חיפוש את התוכן הרלוונטי. מה דעתכם על תוכן מסוג זה? כדי לחסום או לא?

שורות Host ו Sitemap מודיעות לרובוטים על כתיבת הקישור של האתר (עם www או ללא) ואת את מקום של מפת האתר. שימו לב!!! לפי התקינה לא צריך להיות רווח בים השורות.

אני לא משתמש בשורות האחרונות, אלה עושה את זה דרך תוסף XML Sitemap (בעתיד אכתוב עליו).

לסיכום: את תכפילו את כמות העמודים באתר כדי להראות "מנופחים", זה לא משתלם בסופו של דבר.